Alla scoperta delle Istituzioni: come difendersi dal terrorismo della disinformazione istituzionale

Tattiche di disinformazione

Un’incredibile emanazione della Cybersecurity and Infrastructure Security Agency (CISA) del governo degli Stati Uniti

Contesto e cornice

In questo saggio fornisco una panoramica delle tattiche di disinformazione riassunte nel sito web CISA.gov della Cybersecurity and Infrastructure Security Agency (CISA) del governo degli Stati Uniti e ho modificato quel documento affinché possa essere utilizzato da individui e organizzazioni che desiderano contrastare le informazioni errate/false e disinformative (MDM, Mis- Dis- Mal- information) provenienti costantemente da governi, aziende, come le grandi aziende farmaceutiche, organizzazioni non governative (come la fondazione Gates) e organizzazioni artificiali di base (come il Center for Countering Digital Hate).

Per ulteriori informazioni sulla CISA, consultare il nostro precedente saggio Substack intitolato “HOW A “CYBERSECURITY” AGENCY COLLUDED WITH BIG TECH AND “DISINFORMATION” PARTNERS TO CENSOR AMERICANS”: THE WEAPONIZATION OF CISA – Interim staff report for the Committee on the Judiciary and the Select Subcommittee.

Oltre alle varie organizzazioni, le informazioni riepilogate di seguito si applicano anche ai soggetti che diffondono MDM, compresi coloro che lavorano per queste agenzie o come individui, con i propri programmi personali.

Tutte le tattiche di disinformazione descritte di seguito vengono già utilizzate contro il movimento per la sovranità sanitaria, i movimenti per la libertà, coloro che si oppongono all’Agenda 2030 delle Nazioni Unite e all’agenda sul clima approvata, al WEF, alle Nazioni Unite e al movimento di resistenza contro la globalizzazione (NWO).

Tattiche di disinformazione

Gli attori della disinformazione includono i governi, le organizzazioni commerciali e senza scopo di lucro, nonché i singoli individui. Questi attori utilizzano una varietà di tattiche per influenzare il pubblico, spingerlo all’azione e causare danni. Comprendere queste tattiche può aumentare la preparazione e promuovere la resilienza di fronte alla disinformazione istituzionale.

Gli attori della disinformazione utilizzano una varietà di tattiche e tecniche per eseguire operazioni di informazione e diffondere narrazioni di disinformazione per una serie di ragioni. Alcuni potrebbero anche essere ben intenzionati ma alla fine falliscono per motivi etici. Usare la disinformazione per scopi benefici è ancora sbagliato

Ognuna di queste tattiche è progettata per rendere più credibili i messaggi degli attori della disinformazione o per manipolare il loro pubblico verso uno scopo specifico. Spesso cercano di polarizzare il loro pubblico come obiettivo al di là delle controverse divisioni politiche o sociali, rendendo il pubblico più ricettivo alla disinformazione.

Questi metodi possono essere utilizzati come armi dagli attori della disinformazione. Analizzando le tattiche comuni, condividendo esempi del mondo reale e fornendo misure concrete per contrastare queste narrazioni con informazioni accurate, le tattiche di disinformazione elencate di seguito hanno lo scopo di aiutare gli individui e le organizzazioni a comprendere e gestire i rischi posti dalla disinformazione. il personale può essere preso di mira da campagne di disinformazione e tutte le organizzazioni e gli individui hanno un ruolo da svolgere nella creazione di un ambiente informativo resiliente.

Tutto questo è ancora un altro aspetto delle tecnologie, delle strategie e delle tattiche della Guerra di Quinta Generazione (o propaganda/PsyWar) che vengono regolarmente implementate su tutti noi dai nostri governi, da aziende e vari attori non statali.

Panoramica sulle tattiche di disinformazione

Creare deepfake e media sintetici: i contenuti multimediali sintetici possono includere foto, video e clip audio che sono stati manipolati digitalmente o interamente fabbricati per fuorviare lo spettatore. Gli strumenti di intelligenza artificiale (AI) possono rendere i contenuti sintetici quasi indistinguibili dalla vita reale. I contenuti multimediali sintetici possono essere utilizzati come parte di campagne di disinformazione per promuovere informazioni false e manipolare il pubblico.

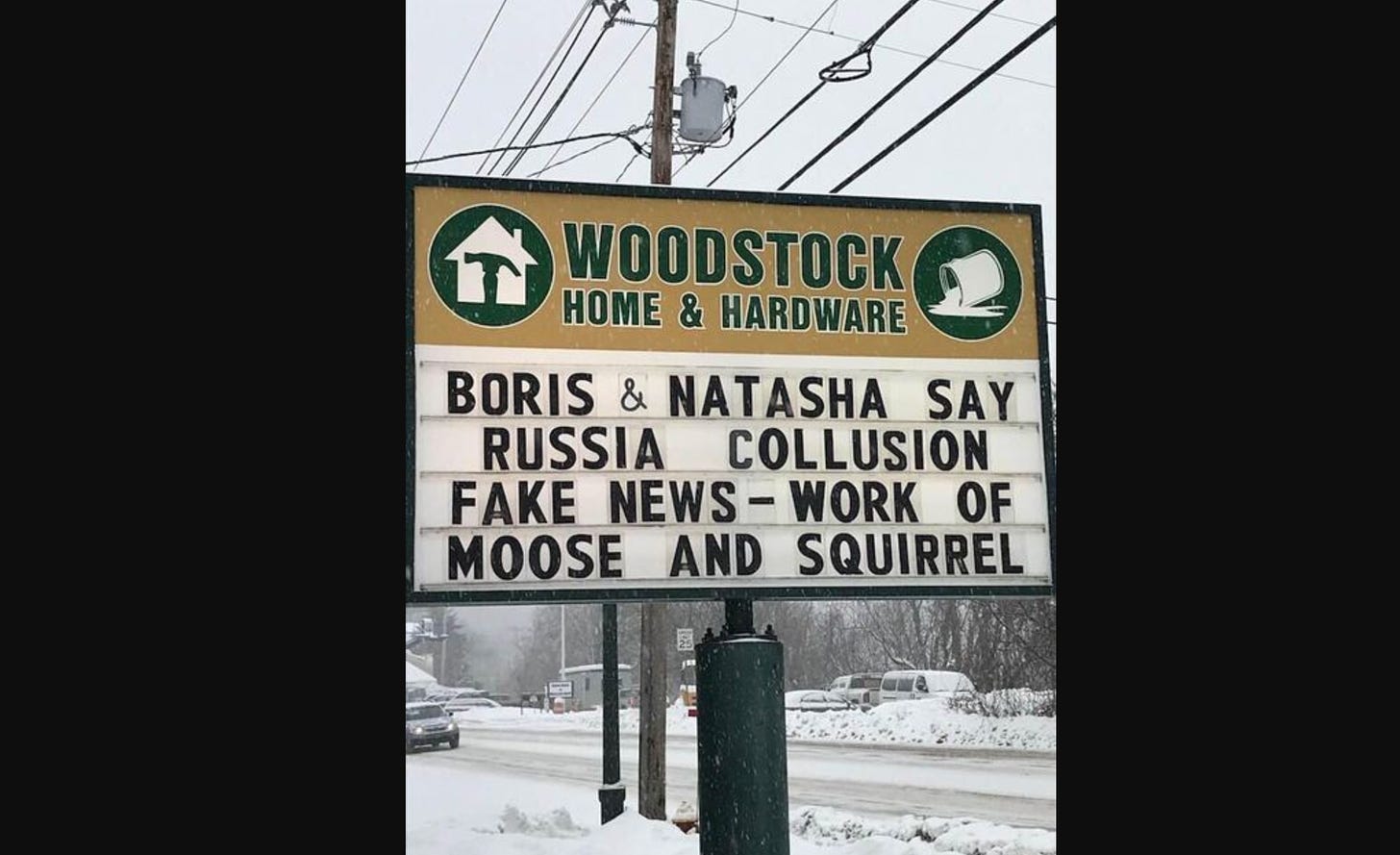

Ideare o amplificare teorie del complotto: le teorie del complotto tentano di spiegare eventi importanti come trame segrete di attori potenti. Le teorie del complotto non influenzano solo la comprensione di un individuo di un particolare argomento; possono modellare e influenzare la loro intera visione del mondo. Gli attori della disinformazione traggono vantaggio dalle teorie del complotto generando narrazioni di disinformazione che si allineano con la visione del mondo della cospirazione, aumentando la probabilità che la narrazione abbia risonanza con il pubblico come obiettivo.

Astroturfing e inondazione dell’ambiente informativo: le campagne di disinformazione spesso pubblicano quantità enormi di contenuti con messaggi uguali o simili da diversi account non autentici. Questa pratica, nota come astroturfing, crea l’impressione di un diffuso sostegno o opposizione da parte della base a un messaggio, nascondendone la vera origine. Una tattica simile, il Floating, prevede lo spam di post e sezioni di commenti sui social media con l’intenzione di modellare una narrazione o soffocare punti di vista opposti.

Abusare di piattaforme alternative: gli attori della disinformazione possono abusare di piattaforme di social media alternative per intensificare la fiducia in una narrativa di disinformazione tra specifici gruppi di utenti. Gli autori della disinformazione potrebbero cercare di trarre vantaggio da piattaforme con minori protezioni per gli utenti, politiche di moderazione dei contenuti meno rigorose e minori controlli per rilevare e rimuovere contenuti e account non autentici rispetto ad altre piattaforme di social media.

Sfruttare le lacune informative: vuoti di dati o lacune informative si verificano quando non ci sono informazioni credibili sufficienti per soddisfare una richiesta di ricerca. Gli attori della disinformazione possono sfruttare queste lacune generando i propri contenuti di influenza e seminando il termine di ricerca sui social media per incoraggiare le persone a cercarlo. Ciò aumenta la probabilità che il pubblico incontri contenuti di disinformazione senza risultati di ricerca accurati o autorevoli per confutarli.

Manipolare attori ignari: gli attori della disinformazione prendono di mira individui e organizzazioni di spicco per amplificare le loro narrazioni. Gli obiettivi spesso non sono consapevoli del fatto che stanno ripetendo la narrativa di un attore di disinformazione o che la narrazione è intesa a manipolare.

Diffusione di contenuti mirati: gli attori della disinformazione producono contenuti influencer su misura che possono entrare in risonanza con un pubblico specifico in base alla loro visione del mondo e ai loro interessi. Questi attori ottengono lo status di insider e sviluppano un seguito online che può rendere più efficaci i futuri sforzi di manipolazione. Questa tattica spesso adotta un approccio di “gioco lungo” per diffondere contenuti mirati nel tempo per creare fiducia e credibilità presso il pubblico di destinazione.

Azioni che puoi intraprendere

Sebbene le tattiche di disinformazione siano progettate per ingannare e manipolare, valutare criticamente i contenuti e verificare le informazioni con fonti credibili prima di decidere di condividerle può aumentare la resilienza contro la disinformazione e rallentarne la diffusione.

- Riconoscere il rischio. Scopri come gli attori della disinformazione sfruttano queste tattiche per promuovere la loro agenda. Diffidare dei contenuti manipolativi che tentano di dividere.

- Interroga la fonte. Valuta criticamente il contenuto e la sua origine per determinare se è affidabile. Ricerca le credenziali dell’autore, considera l’agenda del punto vendita e verifica i fatti a sostegno.

- Esamina il problema. Condurre una ricerca approfondita e imparziale sulle questioni controverse esaminando ciò che dicono fonti credibili e considerando altre prospettive. Affidarsi a fonti di informazione credibili, come i siti governativi.

- Pensa prima di condividere. Rallentare. Non fare clic immediatamente per condividere i contenuti che vedi online. Controlla prima i fatti. Alcune delle disinformazioni più dannose si diffondono rapidamente attraverso post condivisi che cercano di suscitare una reazione emotiva che prevalga sul pensiero critico.

- Parla con la tua cerchia sociale. Partecipa a conversazioni private e rispettose con amici e familiari quando li vedi condividere informazioni che sembrano disinformazione. Sii attento a ciò che pubblichi sui social media.

Le sezioni successive illustrano in modo più dettagliato le tecnologie, le tattiche e le strategie comuni di disinformazione.

Coltivare personaggi e siti Web falsi o fuorvianti

Gli autori della disinformazione aumentano anche la credibilità di questi personaggi falsi generando articoli o documenti di ricerca falsificati e condividendoli online. A volte, questi personaggi e le pubblicazioni ad essi associate vengono intenzionalmente amplificati da altri attori. In alcuni casi, questi materiali vengono condivisi involontariamente anche da organizzazioni e utenti legittimi. La creazione o l’amplificazione di contenuti provenienti da questi personaggi falsi rende difficile per il pubblico distinguere i veri esperti da quelli falsi.

Gli avversari hanno anche dimostrato un approccio di “gioco lungo” con questa tattica, costruendo seguito e credibilità con contenuti apparentemente innocui prima di spostare la loro attenzione sulla creazione e sull’amplificazione della disinformazione. Ciò conferisce una falsa credibilità alle campagne.

Esempio: nel corso della crisi COVID, sono stato preso di mira da numerosi personaggi e siti Web fuorvianti (compresi autori di substack). È estremamente inquietante vedere frammenti del mio CV, della mia vita, dei miei documenti sottoposti a revisione paritaria sezionati, riconfigurati, persino modificati per prendermi di mira. Evidentemente perché qualche governo e/o organizzazione percepisce le mie idee come pericolose.

C’è una persona su Twitter con quasi 100.000 follower che ha letteralmente pubblicato migliaia di post contro di me. Ad un certo punto, Jill ha scattato degli screenshot di tutti questi post e li ha inseriti in un documento di riepilogo. Ha abbandonato il progetto intorno alla pagina 1500. Il file era troppo grande per essere gestito facilmente. Ogni giorno, da anni, questo attore di disinformazione pubblica da due a tre pezzi di successo su di me, mescolati ad altri contenuti. Ha utilizzato ognuna di queste tattiche descritte sopra. Chiaramente viene pagato da un’organizzazione o da un governo. Si autodefinisce giornalista indipendente e ha una lunga e ben documentata storia di cyberstalking e diffusione di falsità. Molti dei suoi seguaci non mettono in dubbio la sua autenticità. Recentemente uno dei follower mi ha addirittura attaccato per aver lavorato allo sviluppo del vaccino Remdesivir! Questi post vengono trasmessi come informazioni autentiche e non posso farci nulla.

Questi frammenti di informazioni false inventate vengono poi diffusi come se fossero informazioni vere e altri influencer riferiscono su questi post come se fossero reali. Il ciclo gira e rigira. Il risultato finale non è solo un danno intenzionale a me stesso e alla mia reputazione, ma anche la delegittimazione dell’intero movimento di resistenza (qualunque esso sia).

Il che è una “vittoria” per quegli agenti del caos che stanno spingendo questa disinformazione.

Creare deepfake e media sintetici

Le foto deepfake di autori di disinformazione possono essere utilizzate per generare immagini di profilo realistiche per creare una vasta rete di account di social media non autentici. I video deepfake utilizzano spesso la tecnologia AI per mappare il volto di una persona sul corpo di un’altra persona. Nel caso dei deepfake audio, un “clone vocale” può produrre nuove frasi come solo audio o come parte di un deepfake video, spesso con solo poche ore (o addirittura minuti) di clip audio di riferimento. Infine, un uso emergente della tecnologia deepfake coinvolge il testo generato dall’intelligenza artificiale, che può produrre una scrittura realistica e rappresenta una sfida unica per la sua facilità di produzione.

Ideare o amplificare teorie del complotto

Gli attori della disinformazione traggono vantaggio dalle teorie del complotto generando narrazioni di disinformazione che si allineano con la visione del mondo della cospirazione, aumentando la probabilità che la narrazione abbia risonanza con il pubblico come obiettivo. Ripetendo alcuni cliché in più narrazioni, gli attori maligni aumentano la familiarità del pubblico target con la narrazione e quindi la sua credibilità. Le teorie del complotto possono anche presentare un percorso per la radicalizzazione verso la violenza tra alcuni aderenti. Le teorie del complotto possono alterare la visione fondamentale del mondo di una persona e può essere molto difficile contrastarla retroattivamente, quindi la costruzione di una resilienza proattiva è particolarmente fondamentale per impedire che il pensiero cospiratorio prenda piede.

Inoltre, le teorie del complotto possono essere utilizzate anche per dividere gruppi e individui scadenti all’interno di un movimento.

Le teorie del complotto possono essere utilizzate anche per screditare un movimento. Le teorie del complotto che non si basano sulla realtà, che possono essere collegate a un movimento o a un’organizzazione, possono essere utilizzate per denigrare quel gruppo come un “elemento marginale”. Da non prendere sul serio o da non soffocare le voci degli esperti.

Astroturfing e inondazione dell’ambiente informativo

Una tattica simile, il Floating, prevede lo spam di post e sezioni di commenti sui social media con l’intento di modellare una narrazione o soffocare punti di vista opposti, spesso utilizzando molti account falsi e/o automatizzati. Le inondazioni possono anche essere definite “manipolazioni antincendio”.

Questa tattica viene utilizzata per soffocare il dibattito legittimo, come la discussione di una nuova politica o iniziativa, e scoraggiare le persone dal partecipare a spazi online. I manipolatori di informazioni utilizzano il Flooding per attenuare la sensibilità degli obiettivi attraverso la ripetizione e creare la sensazione che nulla sia vero. I ricercatori chiamano queste tattiche “censura tramite rumore”, in cui le narrazioni amplificate artificialmente hanno lo scopo di soffocare tutti gli altri punti di vista. L’intelligenza artificiale e altre tecnologie avanzate consentono di implementare l’astroturfing e l’allagamento in modo rapido e su vasta scala, manipolando più facilmente l’ambiente informativo e influenzando l’opinione pubblica.

Abusare di piattaforme alternative

Le piattaforme alternative spesso promuovono chat non moderate e funzionalità di condivisione/archiviazione di file, il che non è intrinsecamente dannoso ma può essere allettante per gli attori che desiderano condividere disinformazione. Sebbene alcune piattaforme alternative vietino la promozione della violenza sui canali pubblici, potrebbero avere meno visibilità canali privati o gruppi che promuovono la violenza. Gli attori della disinformazione recluteranno follower su piattaforme alternative promuovendo un senso di comunità, uno scopo condiviso e la percezione di minori restrizioni. I gruppi su piattaforme alternative possono operare senza le capacità di controllo o rilevamento di cui dispongono altre piattaforme. Spesso i gruppi si concentrano su questioni o attività specifiche per costruire la fiducia del pubblico e gli attori della disinformazione possono, a loro volta, abusare di questa fiducia e di questo status per stabilire credibilità su altre piattaforme.

Sfruttare le lacune informative

Poiché i termini specifici che creano vuoti di dati sono difficili da identificare in anticipo, le fonti di informazione credibili spesso non sono in grado di mitigare in modo proattivo il loro impatto con informazioni accurate. Gli autori della disinformazione possono sfruttare le lacune di dati per aumentare la probabilità che un bersaglio incontri disinformazione senza informazioni accurate per il contesto, aumentando così la probabilità che il contenuto sia considerato vero o autorevole. Inoltre, le persone spesso percepiscono le informazioni che trovano sui motori di ricerca come più credibili e può essere difficile invertire gli effetti della disinformazione una volta accettate.

Naturalmente, bisogna riconoscere che “Googlenet” e altri motori di ricerca mettono i siti web governativi e le “fonti attendibili” prima delle altre fonti di informazione. Ricorda, solo perché è il primo termine trovato su Google non lo rende più vero.

A Googlenet non piacciono i vuoti di dati. Pertanto, quando a Google non piace l’analisi di un termine di ricerca o incontra un vuoto di dati, colma la lacuna con le informazioni che gli piacciono. Googlenet è stato addirittura sorpreso a manipolare manualmente i risultati di ricerca. Questo è quello che è successo con il termine di ricerca “formazione delle psicosi di massa” utilizzato per descrivere la risposta pubblica alla crisi del COVID. Poiché questo termine andava contro la narrativa del COVID, la sua legittimità è stata rapidamente soffocata da Googlenet.

Manipolare attori ignari

Le campagne di disinformazione prendono di mira individui e organizzazioni di spicco per contribuire ad amplificare le loro narrazioni. Questi diffusori secondari di narrazioni di disinformazione aggiungono credibilità percepita al messaggio e aiutano a diffondere queste narrazioni a livello di base, mascherando la loro fonte originale. Gli obiettivi spesso non sono consapevoli del fatto che stanno ripetendo la narrazione degli attori della disinformazione o che la narrazione è intesa a manipolare. Il contenuto è progettato per fare appello alle emozioni loro e dei loro follower, facendo sì che gli influencer diventino facilitatori inconsapevoli di campagne di disinformazione.

Diffondi contenuti mirati

Gli attori della disinformazione sorvegliano una comunità online mirata per comprenderne la visione del mondo, gli interessi e i principali influencer e quindi tentano di infiltrarsi pubblicando contenuti di influenza su misura che possano entrare in risonanza con i suoi membri. Iniziando con post divertenti o non controversi che siano graditi alle comunità prese di mira, gli attori della disinformazione ottengono lo status di “insider” e sviluppano un seguito online che può rendere più efficaci i futuri sforzi di manipolazione. Questa tattica può essere utilizzata in combinazione con la coltivazione di falsi esperti, che diffondono contenuti mirati nel tempo, adottando un approccio di “gioco lungo” che conferisce falsa credibilità alla campagna. I contenuti mirati spesso assumono forme altamente condivisibili, come meme o video, e possono essere fatti per raggiungere un pubblico molto specifico con metodi come la pubblicità a pagamento e lo sfruttamento degli algoritmi dei social media.

Conclusione

In un articolo pubblicato su USA Today il 3 ottobre 2023 intitolato “La Corte d’appello federale espande i limiti dell’amministrazione Biden nel caso del Primo Emendamento “, i giornalisti Jessica Guynn e John Fritze riassumono lo stato attuale del caso legale chiave che sta rivelando l’utilizzo come arma della CISA contro la popolazione americana.”

La principale agenzia di difesa della sicurezza informatica della nazione probabilmente ha violato il Primo Emendamento quando ha esercitato pressioni sulle aziende della Silicon Valley per rimuovere o sopprimere la diffusione di contenuti online sulle elezioni, ha stabilito martedì una corte d’appello federale.

La Corte d’Appello del 5° Circuito ha ampliato un’ingiunzione emessa a settembre per includere la Cybersecurity and Infrastructure Security Agency, stabilendo che utilizzava frequenti interazioni con le piattaforme dei social media “per spingerle ad adottare politiche più restrittive sui discorsi legati alle elezioni”.

La precedente decisione di una giuria di tre giudici – nominati dai presidenti repubblicani – ha concluso che le azioni della Casa Bianca di Biden, dell’FBI e di altre agenzie governative probabilmente violavano il Primo Emendamento ma che la CISA – che ha il compito di proteggere le elezioni dalle minacce online – ha tentato di convincere, non di costringere.

I procuratori generali repubblicani, che hanno portato avanti il caso, hanno chiesto una nuova udienza. Nell’ordinanza di martedì, i giudici del 5° Circuito hanno stabilito che la CISA ha facilitato le interazioni dell’FBI con le società di social media.

L’ordine impedisce alla CISA e ai massimi funzionari dell’agenzia, tra cui il direttore Jen Easterly, di adottare misure per “costringere o incoraggiare in modo significativo” le aziende tecnologiche a rimuovere o limitare la diffusione dei post sui social media.

Il Dipartimento di Giustizia ha rifiutato di commentare. La CISA, che fa parte del Dipartimento per la Sicurezza Nazionale, ha affermato di non commentare le controversie in corso, ma il direttore esecutivo Brandon Wales ha affermato in una dichiarazione che l’agenzia non censura i discorsi né facilita la censura.

La causa è stata intentata dai procuratori generali del Missouri e della Louisiana, nonché da individui che hanno affermato che il loro discorso è stato censurato.

“La CISA è il ‘centro nevralgico’ della vasta impresa di censura, la stessa entità che ha collaborato con l’FBI per mettere a tacere la storia del laptop di Hunter Biden”, ha twittato il procuratore generale del Missouri Andrew Bailey.

La CISA sapeva esattamente cosa stava facendo e come realizzare l’agenda di censura e propaganda dell’amministrazione Obama/Biden. A questo punto restano tre domande chiave

- Cosa farà la Corte Suprema riguardo alle violazioni del Primo Emendamento da parte della CISA e dell’amministrazione Biden? Qual è il rischio maggiore, ovvero la cattiva informazione distribuita ai cittadini statunitensi dallo Stato amministrativo dell’USG, o i cittadini statunitensi che discutono informazioni e idee che lo Stato amministrativo dell’USG non vuole che vengano discusse, e quindi le definisce disinformazione.

- Cosa intendi fare tu al riguardo?

Per favore, tieni presente dove tutto è iniziato.E ricorda anche che nella Guerra di quinta generazione, altrimenti nota come Guerra Psicologica, la battaglia è per il controllo della tua mente, dei tuoi pensieri, delle tue emozioni e di tutte le informazioni a cui sei esposto. L’unico modo per vincere alla Guerra Psicologica è non stare al gioco. Non appena entri in contatto con i media aziendali o con i social media, entri nel campo di battaglia. Perciò sii cauto là fuori.

Conosci la tecnologia, le tattiche e la strategia dei tuoi avversari. Il terreno del campo di battaglia della Guerra Psicologica è tortuoso, bizzarro, in costante cambiamento e pericoloso per la tua salute mentale. I nostri avversari non fanno alcuna distinzione tra combattenti e non combattenti e non riconoscono limiti morali a ciò che faranno per raggiungere i loro obiettivi.